How does my typical betting weekend looks like, when I start ckecking, whether there are some interesting matches? I start my laptop, open the browser, start my Python program, start the database and after some minutes, I am able to start my data prcoessing, which collects all the data and calculates the predictions. That’s already great, but wouldn’t it be even better to have all predictions always already up-to-date? This blog will show you how to setup and run a small automated data pipeline in AWS, which extracts all stats from Understat.com. mehr…

Data Strategy

Data Strategy

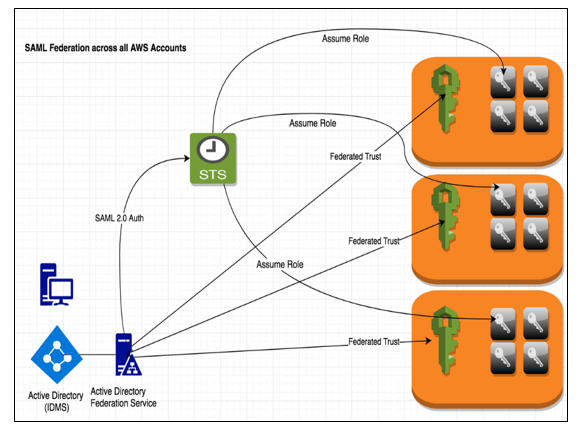

Data Governance

- Data Quality

- Data Catalog

Data Platform

Agile BI

Data Driven Company

Hitchhikers Guide to the Data Galaxy®

Data Governance

- Data Quality

- Data Catalog

Data Platform

Agile BI

Data Driven Company

Hitchhikers Guide to the Data Galaxy®

Data Analytics

Visual Analytics

Information Design

Self-Service BI

IBCS konformes Reporting

Reporting

Dashboarding

Sports Analytics

- Sports Analytics mit AWS

Information Design

Self-Service BI

IBCS konformes Reporting

Reporting

Dashboarding

Sports Analytics

- Sports Analytics mit AWS

Cloud Computing

Modern Cloud Data Stack

Cloud Migration

Cloud DWH

Cloud Engineering

Cloud Referenzarchitekturen

Microsoft Azure Cloud Solutions

AWS

- BI & Analytics mit AWS

Multicloud

Cloud Migration

Cloud DWH

Cloud Engineering

Cloud Referenzarchitekturen

Microsoft Azure Cloud Solutions

AWS

- BI & Analytics mit AWS

Multicloud

Operations

Data Platform Operations

Data Infrastructure Op.

Managed Cloud Services

Managed Cloud Applications

Monitoring

Data Infrastructure Op.

Managed Cloud Services

Managed Cloud Applications

Monitoring

Data Engineering

Data Engineering

Cloud Engineering

DevOps Engineering

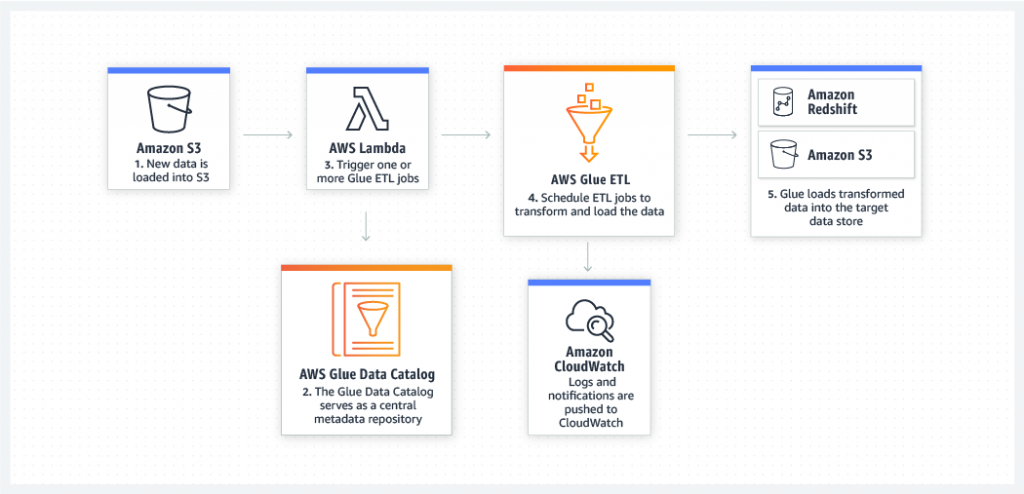

Data Pipelines

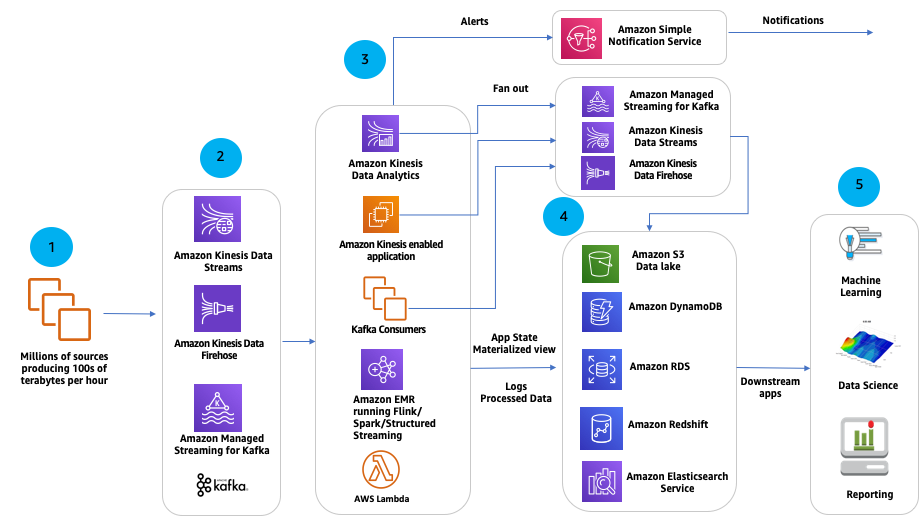

Data Streams

CI/CD

Cloud Engineering

DevOps Engineering

Data Pipelines

Data Streams

CI/CD